Les géants de l’intelligence artificielle s’allient pour garder le contrôle du secteur

Un mois après l’ouverture du trilogue sur la proposition de règlement européen relative à l’intelligence artificielle (IA, Artificial Intelligence Act), Google, Microsoft, OpenAI et Anthropic créent le Forum des modèles d’avant-garde (Frontier Model Forum) pour « garantir un développement sûr et responsable des modèles d’IA d’avant-garde » : ils s’allient pour s’autoréguler.

Surveillance de l’IA : l’auto-régulation à l’américaine

En mars 2023, un appel à la suspension du développement de l’IA avait été lancé par Steve Wozniak et Elon Musk entre autres et rejoints par plus de 33 000 signataires à ce jour. Deux mois après, des dirigeants de sociétés développant des systèmes d’IA dont Sam Altman, CEO d’OpenAI (ChatGPT) signaient une lettre ouverte alertant le public sur les « risques d’extinction » de l’humanité encourus du fait de ces technologies comparables à une guerre nucléaire, sans pour autant en fermer l’accès aux 25 millions de visiteurs quotidiens (statement on AI risks).

Le Sénat américain a donc auditionné en sous-comité le 16 mai Christina Montgomery (IBM), le Pr Gary Markus (New York Universty) et le CEO d’OpenAI. Témoignant devant les sénateurs, celui-ci affirma être largement d’accord avec eux sur la nécessité de réglementer l’IA de plus en plus puissante.

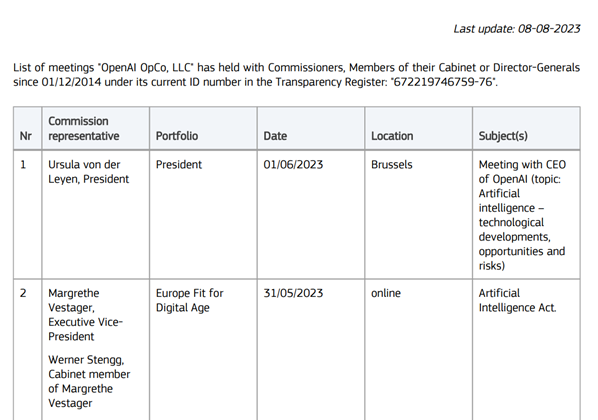

A-t-il tenu le même discours au législateur européen lors de sa visite à la présidente de la Commission européenne en juin ?… Rien n’est moins sûr.

Source : Transparency Register, europa.eu.int

En tous cas en juillet, Amazon, Microsoft, Google, Meta et OpenIA notamment s’engageaient auprès de la Maison Blanche à réguler les IA génératives avec :

- un système de marquage des contenus pour identifier les fausses photos et vidéos,

- des audits indépendants et un partage des informations avec l’administration,

- une limitation des biais pour lutter contre les discriminations et

- un emploi responsable à des fins de lutte contre le changement climatique et contre le cancer.

Ces engagements sont purement volontaires et non assortis de sanction et ne couvrent pas deux aspects essentiels des IA génératives : les contenus illégaux et la transparence des données utilisées pour entraîner l’IA.

Finalement, tout comme la cybersécurité, les systèmes d’IA ne peuvent être régulés aux Etats-Unis au niveau fédéral sans le soutien des puissances globales que représentent les GAMAM.

Les amendements à l’IA Act adoptés par le Parlement européen

Europol a averti que les IA génératives pourraient augmenter considérablement la cybercriminalité et de nombreux experts en intelligence artificielle sont profondément inquiets quant à leur potentiel à créer un tsunami de désinformation, constituant une sérieuse menace notamment dans le cadre d’élections.

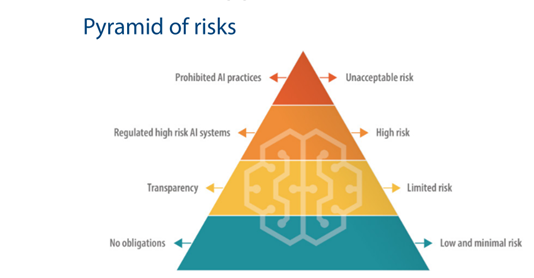

La proposition de règlement sur l’IA formulée par la Commission européenne a donc connu des amendements substantiels en juin au Parlement européen :

- Révision de la définition des systèmes d’IA,

- Elargissement de la liste des systèmes d’IA interdits et

- Imposition d’obligations sur les modèles d’IA à usage général et d’IA générative comme ChatGPT.

Néanmoins, les modèles d’IA de base génératifs (tels que ChatGPT) qui utilisent de grands modèles de langage (large language models, LLM) pour générer de l’art, de la musique et d’autres contenus seraient soumis à des obligations de transparence strictes (amendement 399).

Le lobbying des big tech a donc porté ses fruits car ChatGPT ne relève pas de la catégorie des systèmes d’IA à haut risque.

Source : Commission européenne

Ainsi, les fournisseurs de systèmes d’IA à finalité générale utilisés dans des systèmes d’IA destinés spécifiquement à générer, avec différents niveaux d’autonomie, des contenus tels que des textes, des images, des contenus audio ou des vidéos complexes (IA générative) et les fournisseurs spécialisés dans la transformation d’un système d’IA à finalité générale en un système d’IA générative devraient :

- Divulguer que le contenu a été généré par l’IA et non par les humains,

- Concevoir leur modèle pour l’empêcher de générer du contenu illégal et

- Documenter et mettre à la disposition du public un résumé suffisamment détaillé de l’utilisation des données d’entraînement protégées par la législation sur le droit d’auteur.

En attendant la mise en place puis l’entrée en vigueur du cadre européen, l’adoption de codes de conduite volontaires et d’un pacte sur l’IA sont envisagés pour atténuer les inconvénients potentiels de l’IA générative. C’est le cas par exemple de la feuille de route conjointe UE – États-Unis (Trade and Technology Council, décembre 2022).

Elle vise à faire progresser les terminologies et les taxonomies partagées pour éclairer les deux approches de la gestion des risques liés à l’IA et d’une IA fiable des deux côtés de l’Atlantique. Il s’agit de construire un référentiel commun de métriques pour :

- Mesurer la fiabilité de l’IA et les méthodes de gestion des risques, et

- Informer et de faire progresser les approches collaboratives dans les organismes internationaux de normalisation liés à l’intelligence artificielle.

Sources

- Pour des principes juridiques de responsabilité adaptés à l’intelligence artificielle – Influence Cyber (influence-cyber.fr)

- Microsoft, Anthropic, Google, and OpenAI launch Frontier Model Forum – Microsoft On the Issues

- Interview Influence Cyber : Artificial Intelligence Act : voici ce que prépare l’Union européenne pour encadrer l’IA (radiofrance.fr)

- Pause Giant AI Experiments: An Open Letter – Future of Life Institute

- Statement on AI Risk | CAIS (safe.ai)

- ➤ ChatGPT : Statistiques et Chiffres Clés (2023) (sales-hacking.com)

- Sam Altman, ChatGPT Creator and OpenAI CEO, Urges Senate for AI Regulation – The New York Times (nytimes.com)

- Minutes de l’audition de Sam Altman, CEO OpenAI, Sénat américain, Submission version — Questions for the Record (senate.gov)

- Amendements du Parlement européen, adoptés le 14 juin 2023, à la proposition de règlement du Parlement européen et du Conseil établissant des règles harmonisées concernant l’intelligence artificielle (législation sur l’intelligence artificielle) et modifiant certains actes législatifs de l’Union (COM(2021)0206 – C9-0146/2021 – 2021/0106(COD))

- The Lobbying Ghost in the Machine.pdf (corporateeurope.org)

- AI Pact : Artificial intelligence | Statement by Commissioner Breton (europa.eu)

Étiquette:ChatGPT, lobbying, OpenIA, Règlement IA